微信扫码对话

「免加好友」

「免加好友」

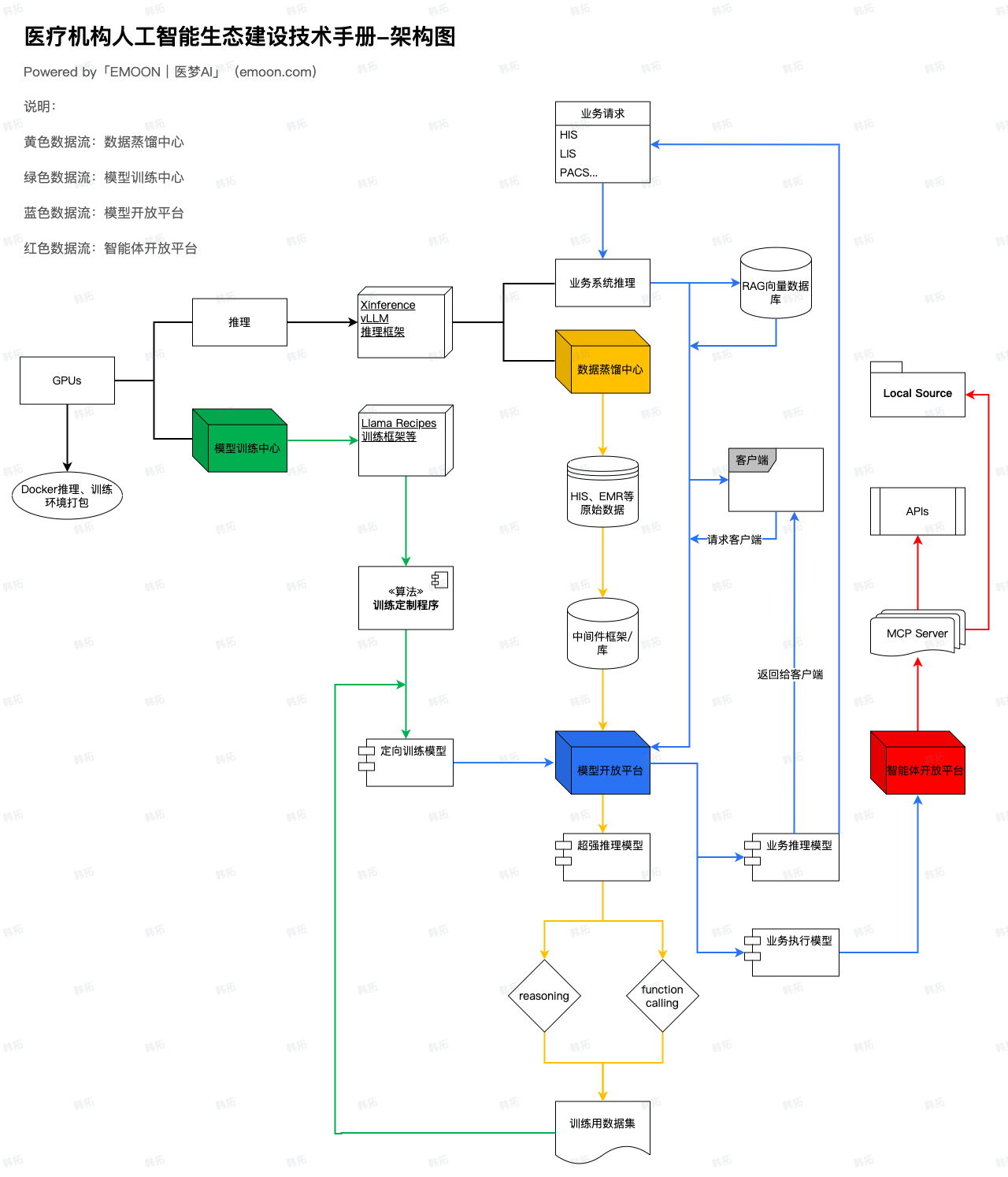

基于医疗机构对 AI 的需求已从单点实验进步至全院级协同,多模型推理与医疗专精模型训练的需求日益增强,医梦 AI GPUs将推理与训练框架进行整合,联合支持信创要求的国产化算力厂商进行深度研发,为医疗机构提供多款集成式GPU服务器,并将该项目命名为GPUs。

GPUs通过对多模型、多模态、高并发的推理框架优化,以及自主研发的的训练框架,为医疗机构提供一体化的可推理、可训练的算力硬件底座,符合行业向标准化、集约化发展的趋势。

"「医梦AI GPUs」旨在为模型训练及推理提供基础硬件算力。"

BY Blazer Han.

GPUs作为AI生态数据流的基础底座,为业务模型推理、专精模型训练提供原始算力,如下图中GPUs数据流所示:

· 数据蒸馏推理

· 业务系统推理

· 模型定向训练

出于对医疗机构的数据安全考虑,医梦AIGPUs仅支持私有云运行,医疗机构可通过购买本地硬件或租用云算力服务平台来实现基础算力。

· 医梦AI EG1 GPU服务器(支持671B)

· 医梦AI EG2 GPU服务器(支持70B)

· 医梦AI EG3 GPU服务器(支持32B)

· 算力定制计划:因业务并发能力需求不同,GPUs方案需视业务而定,请私信我们进行算力定制。